この運営ブログのタイトル「dtn 運営ブログ」で検索をしてみたところ、検索結果にこのブログとタイトルがほぼ同じで、説明文が全く同じ別ドメインのサイトがあることに気が付きました。場所は同じ1枚目の下の方といった感じです。

検索結果に表示されているURL(blog.dtn.jp.cutestat.com)を調べてみると、海外のドメイン情報解析サイトといったものということが分かりました。

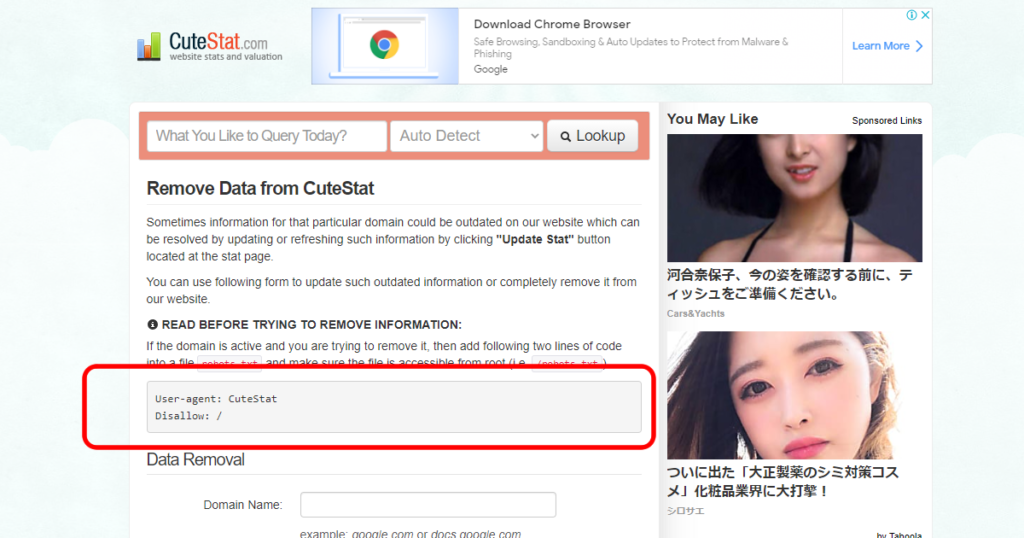

コピーサイトということでGoogleから消し去ってもらえないかを調べようかと思いましたが、このサイトを見てみると、ご丁寧にデータ削除機能とcutestat.comのクローラーをrobots.txtではじくマニュアルまで置いてありましたので、早速やってみることにしました。

この記事では、このタチの悪いドメイン解析サイトのCuteStat.comからデータを削除する方法と、WordPress標準のrobots.txtに対して、プラグインを使わず、functions.phpにフィルター関数を使うことでロボット除けの追記をする方法をご紹介しています。

解析サイトCuteStat.com

ブログのタイトル「dtn 運営ブログ」で検索してみたところ、検索結果にこのブログとタイトルがほぼ同じサイトがすぐ下あたりにあることに気が付きました。説明文の方は全く同じです。

タイトル:Blog Dtn : dtn.jp運営ブログ – 2002年から始めた個人サイトdtn….

blog.dtn.jp.cutestat.comのタイトル

タチの悪いCuteStat.comの解析ページ

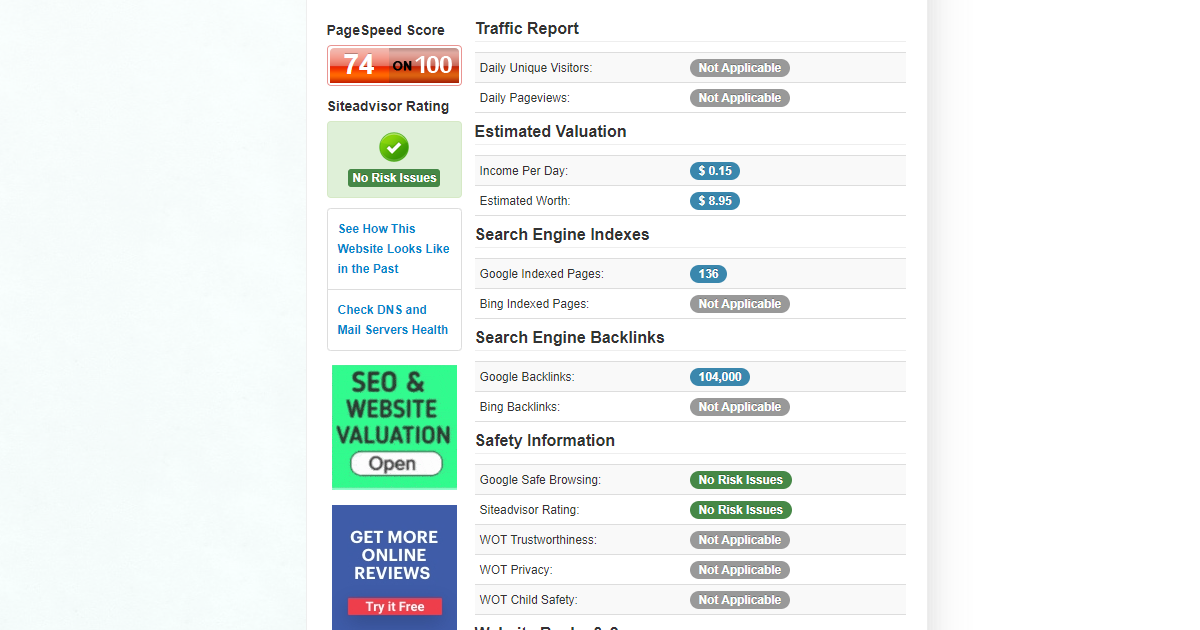

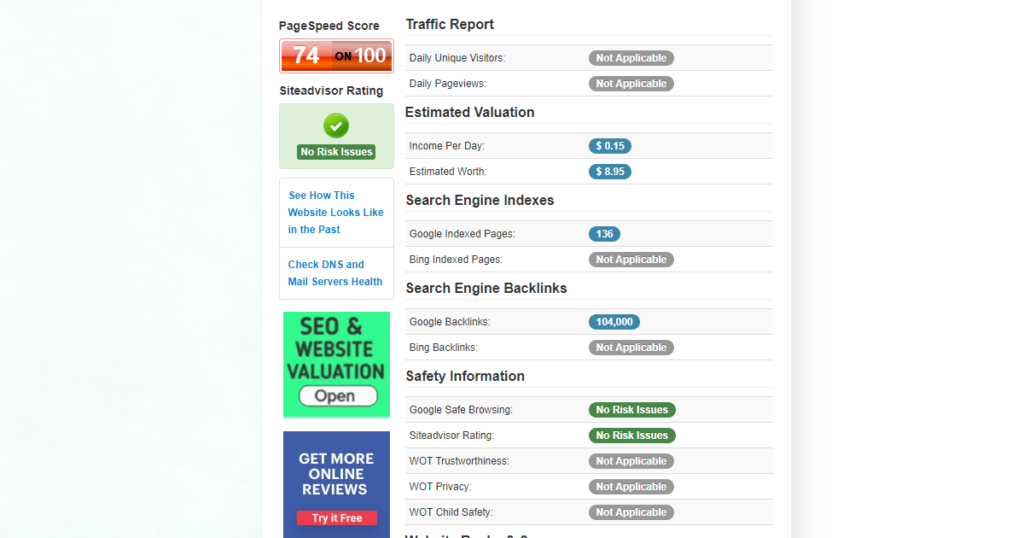

リンク先を見てみると、ドメインの検索エンジンバックリンクやインデックス数、一日あたりの収益推定値といった値が並ぶページが出ており、どうやらドメインの解析サイトといったもののようでした。広告もペタペタ張ってあるので、そっちがメインのサイトかもしれないです。

このサイトのタチが悪いところが、解析ページのTITLEやDESCRIPTIONがそのまま当サイトから抜き出した文字列を表示させており、faviconまで引っこ抜いて同じものを設定するという手の込んだパクリ仕様にしてくれているところです。

下記は当ブログドメインのCuteStat解析ページで使われている<head>タグですが、タイトルは収集した当ブログの文字列をほぼそのまま使ってしまっており、<meta =”description”>タグは完全に同じ文字列を表示させてしまっています。

弱小ブログの当サイトのブログタイトルでググると、このCuteStat解析ページの方がアクセスがあるのか、かなり上位に表示がされてしまうという悲しい状況になっていました。

<html>

<head>

<meta charset="utf-8">

<title>Blog Dtn : dtn.jp運営ブログ – 2002年から始めた個人サイトdtn.jpの開発運用ブログです</title>

<meta name="description" content="PHPとSQLとYahoo API、Google APIで制作したディレクトリ型検索エンジンdtnの開発運用ブログです。サイト開発や運営、プログラムやSQL、日々の出来事や雑記を不定期で記録しています。">

<link rel="canonical" href="https://blog.dtn.jp.cutestat.com">

<link rel="icon" type="image/png" href="https://favicon.cutestat.com/blog.dtn.jp">robots.txtでクローラーを避ける

気分が悪いので、データ削除をできないかと探してみたところ、ページ最下部に「Update or Remove」といった画面があり、嫌ならこちらから削除をせよとのことなので、取り急ぎデータを削除しようと思いました。

ただ、削除するならrobos.txtでクローラー除けを書いておいてくれとのことで、合わせて設定をしておくことにしました。

User-Agent : CuteStat

CuteStat.comのロボットはUser-Agent: CuteStatとなっているようです。これをDisallow:でルートの / を付けて弾いてとのことでした。

User-Agent: CuteStat

Disallow: /WordPressのデフォルト記載に追記

WordPressをお使いの方ならご存知と思いますが、WordPressには/wp-adminにロボットが巡回してデータを拾わないよう、デフォルトでrobots.txtの出力設定が入っています。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpここに追記をしたいと思いますが、robots.txtの出力をしているphpがなかなか見つからず、調べてみたところcustome_robots_txt_filter()というrobots.txt用のフィルター関数をfunctions.phpに追記で対応可能と書いてあったので、これで追記をしてみることにしました。

中華系の検索エンジンのロボットはしつこいのでそういったロボットを排除するためにrobots.txtに追記したいんですが、WordPressを使っていて実体ファイルを作成してしまうとプラグインなどでrobots.txtをカスタマイズしている場合にプラグイン側の設定が反映できないので、ここでは

tamulab.jpさんの記事robots_txtフィルターを使ってカスタマイズしてみます。

functions.php

先ほどのブログで紹介されてたフィルター関数を使い、CuteStat指定の記述をfunctions.phpに足しておきました。

//sitemap.txtに追記する

function custome_robots_txt_filter($output = '', $public = true){

$output .= "User-Agent: CuteStat\n";

$output .= "Disallow: /\n";

return $output;

}

add_filter('robots_txt', 'custome_robots_txt_filter', 10, 2);Googleのrobots.txtテスター

先ほどのフィルター関数を設定してみたところ、無事にrobots.txtにUser-Agent : CuteStat分が追加されておりました。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

User-Agent: CuteStat

Disallow: /念のため、Googleが提供しているrobots.txtテスターで更新されたrobots.txt をテストしてみましたが、OK(200)が表示されておりました。

robots.txtの追記が無事完了したので、「Update or Remove」からblog.dtn.jpを削除してみたところ、無事にデータが消滅してくれました。

おわりに

先ほど、同じようにブログタイトルでググってみたところ、CuteStatのパクリページはだいぶ順位が下がってくれていました。この記事を書こうと思ってスクショを取ったのが11月中なので、二週間程度で評価がガクっと下がってくれたようです。助かりました。